本記事では、Reddit上のやりとりをもとにLLMチャットボットのリスクを分析した事例を紹介します。

調査ではから見えてきたのは、モデルごとに異なるリスクの特徴と、利用者の感じ方の違いでした。

まずは手法の流れを追いながら、実務にも応用しやすいポイントを読み解いていきます。

背景

LLMは日常生活のさまざまな場面に広がりつつあります。コードのデバッグ、記事の執筆、情報収集、コンテンツ作成など、用途は多岐にわたります。もはや道具ではなく、協力者やアシスタントとして扱われる場面も増えています。

一方で、リスクも見過ごせません。有害な出力や事実と異なる出力、差別的なバイアス、セキュリティの脆弱性などが報告されています。

こうした課題の多くは、これまでシステム側の視点から論じられがちでした。多くの研究が実験室内で行われており、日常利用の中で生じる予期しないリスクには十分に目が向けられていません。研究者の想定と、実際の利用者が感じるリスクの間にズレがある可能性もあります。

プライバシーの懸念や、医療分野での偏った提案など、利用者が直面する問題は幅広いものです。LLMが公共空間で使われるようになり、満足度や信頼、プライバシーとのバランスなど、ユーザー体験に注目する研究も進み始めています。

ただ、複数のチャットボットが併用される現在の状況を踏まえると、もっと広い視野が必要です。

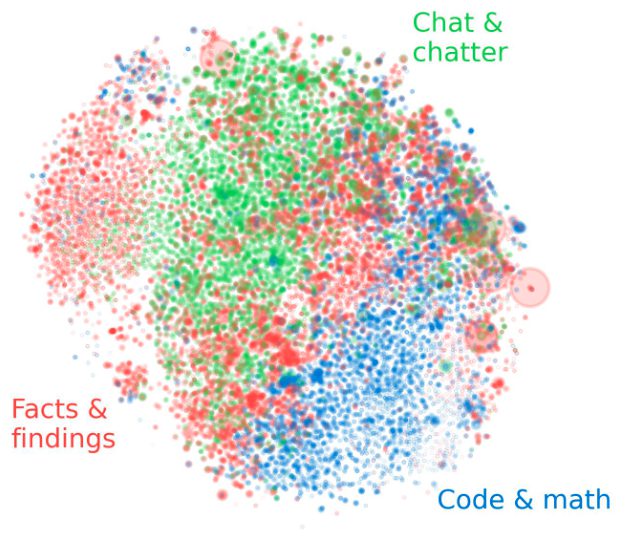

そこで本記事では、Reddit上の大規模なやりとりに着目し、ユーザーの視点からLLMのリスクを多面的に捉えることを目指した取り組みを紹介します。