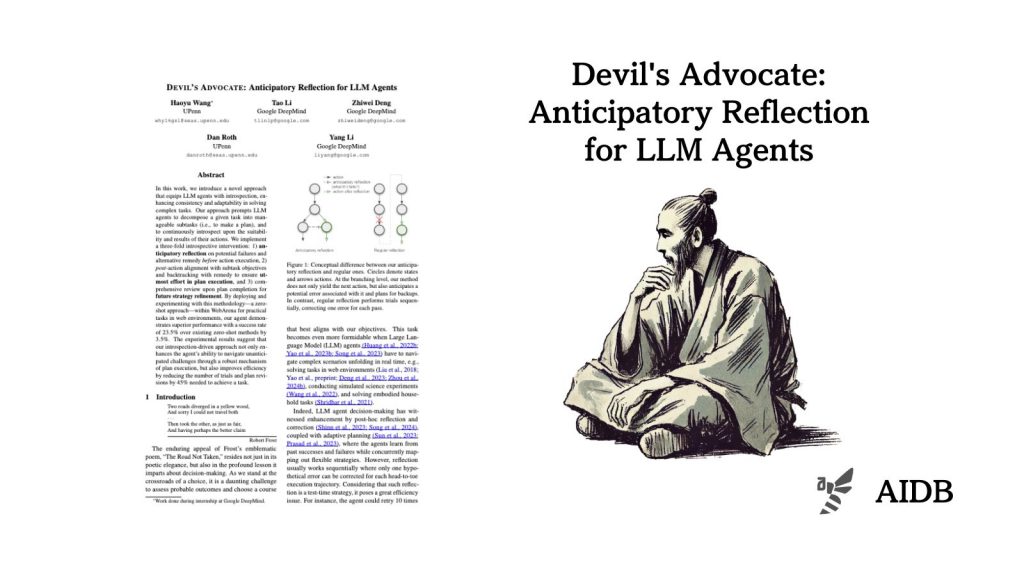

本記事では、LLMエージェントの問題解決能力を向上させる「内省」アプローチの研究を紹介します。タスクの分解と”3つの”内省メカニズムを通じて、エージェントの適応力と一貫性を向上させる手法です。

参照論文情報

- タイトル:Devil’s Advocate: Anticipatory Reflection for LLM Agents

- 著者:Haoyu Wang, Tao Li, Zhiwei Deng, Dan Roth, Yang Li

- 所属:UPenn, Google DeepMind

背景

LLMエージェントが複雑なタスクを遂行する能力が注目されています。しかし、予期せぬ状況に直面した際の適応力や一貫性には課題があることが指摘されています。

そこで、タスク実行後の振り返りなどが提案され、過去の成功や失敗から学習し、柔軟な戦略を立てることが試されてきました。しかし、振り返りは通常1つの(仮想的な)エラーを修正するだけであり、効率性に問題があります。

また、計画の頻繁な変更はLLMエージェントに混乱をもたらすことが懸念されています。人間にとっては単なる不便さかもしれませんが、LLMエージェントにとっては方向性を失ったり、停滞したり、さらには失敗の無限ループに陥る可能性があります。

そこで今回研究者らは、一貫性と適応性のバランスを最適化する方法論を提案しています。予期せぬ事態に備えながら計画を実行するための方法です。

タスクをサブタスクに分解し、行動と結果について内省を行うよう、LLMエージェントに促すのがポイントです。

結果としてタスク達成に必要な試行回数と計画修正回数が大幅に削減され、効率性の向上にもつながることがわかりました。

以下で詳しく見ていきます。